·“目前基于AI的设备都是辅助诊断设备,最后的决定权掌握在医生手里,所以责任方是医生,这也是AI的长期发展趋势。我们不应该过分担忧AI会取代人类,而应该把AI视为一个工具。在人类的工作中,我们一直强调的是解决问题的能力,在未来,我们需要掌握使用AI工具解决问题的能力。”李文文说,“目前ChatGPT是一个通用的系统,对一个特定任务来说,它现在的性能还不够。我们希望对它进行特别的训练,让它能够完成跟...

·“目前基于AI的设备都是辅助诊断设备,最后的决定权掌握在医生手里,所以责任方是医生,这也是AI的长期发展趋势。我们不应该过分担忧AI会取代人类,而应该把AI视为一个工具。在人类的工作中,我们一直强调的是解决问题的能力,在未来,我们需要掌握使用AI工具解决问题的能力。”

李文文说,“目前ChatGPT是一个通用的系统,对一个特定任务来说,它现在的性能还不够。我们希望对它进行特别的训练,让它能够完成跟有抑郁倾向的人良好对话的目的。我们一定会明令禁止它输出某些方面的内容,比如涉及歧视的、消极情绪的内容。”“我们主要做的是收集人们在网上发布的各类公开内容,例如社交媒体上的帖子,使用AI自动识别可能存在抑郁倾向的那些人。这其中用到的主要就是自然语言处理(NLP)技术。现在很多人压力很大,我们也关注到很多可能有抑郁倾向的人不会主动寻求帮助。我们希望借助机器主动识别这些人,主动提供一些帮助,再把筛查出来的高危人群反馈给相关专业机构或人员,做进一步识别,提供进一步的帮助。”近日,复旦大学管理学院首档自制播客节目《开挂》上线,首期对话邀请了复旦大学管理学院信息管理与商业智能系助理教授李文文,探讨了人工智能在医疗健康领域的具体应用。

李文文表示,人工智能(AI)对图像的处理已经达到了非常先进的程度,基于此,它可以辅助医生看诊。AI辅助看片系统已经应用于各大医院,它可以辅助医生进行CT或其他各类扫描图片。

另一方面,当前最火的ChatGPT,属于自然语言处理(NLP),它可以做到和患者进行良好的沟通,从而减轻医生的压力。具体来说,ChatGPT可以被引入智能问诊系统,在病人看病之前,先由AI大致了解病人需求,快速把病人和所需要的医生对接起来。

但问题在于,ChatGPT只会回答,不会继续某一个话题。李文文表示,一个比较好的解决方案是预先给智能问诊系统设置一套流程。“例如,问诊时医生会询问患者的基本家庭情况、健康情况、过往用药情况、近期有没有手术记录等,这些流程是可以规则化的。可以设置好这套流程,让AI自己判断已经询问过的问题和尚未询问的问题,并主动地询问患者。”

AI防治眼病和识别抑郁倾向

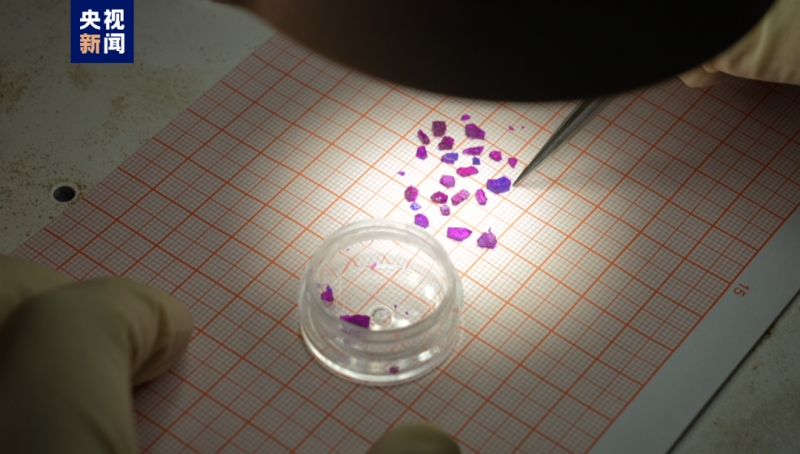

每当被问及AI在医疗健康领域究竟如何落地,李文文总会想到她和上海市眼病防治中心合作的AI防治眼病项目。“现在很多人可能都患有潜在的眼病,尤其是老年人,但由于意识不足,大家不会主动去医院检查。政府部门会组织医院主动走进社区,提供免费的眼病筛查服务,如果居民筛查出问题,医生会建议转诊,进行进一步的治疗。但由于眼科是一个比较小的科室,尤其在社区医院,一般就是五官科,一位医生要看诊五官的所有问题,医生的数量有限,专业程度也有限,很多时候没有办法达到很好的筛查效果。”李文文介绍。

于是,上海市眼病防治中心购入了一批AI眼病筛查仪器,投放到社区,居民或患者可以随时做免费的筛查。“以往在社区做筛查,患者眼底拍了照片,需要上传到云端,给远程的专家做筛查,专家诊断完再反馈给病人,一个来回需要1-2个月时间。而AI可以当场诊断出结果,只需要一分钟就可以完成这个流程。”李文文说。

李文文介绍,目前大部分居民通过两种方式参与检测。有些社区会搭建“健康小屋”或摊位,通过给居民发放宣传单或让家庭医生宣传的方式,告知居民可以免费做眼病筛查。另一方面,社区的很多老年人经常去就近去社区医院看诊,看诊时医生也会告知他们有免费的眼病筛查。“年轻人可能由于时间有限,不太愿意做,老年人一般很愿意做,效果也比较好。”

李文文正在做的另一个项目是利用AI识别人的抑郁倾向。要做到这点,首先要让AI明白词语背后的含义。“比如我们看到‘谈话’两个字,首先要让AI认出来这是‘谈话’,这是第一层含义;其次要知道‘谈话’这个词背后的含义是两个人要沟通,这是第二层含义。”李文文举例,“我们发现,借助图像识别技术,让计算机识别这两个字不会很难,但让计算机理解这个词背后的意思比较有挑战。我们的语言中可能有多义词,比如‘包袱’,有时候指行李包袱,有时候也说‘你不要有思想包袱’。如何让计算机理解多义词在一个场景中的含义,是NLP一直在解决的问题。”

李文文解释,简单来说,其具体的解决方式是,把一个字或词用高维的向量表示出来,例如一个300维的向量,就用300个可能具有不同含义的数字来表现。“使用高维向量是因为语言是一个非常复杂的系统,包含的信息非常多,用比较高的维度可以更好地拟合它包含的信息。”

把文字转化成高维的向量后,再把它们放到深度学习的模型中。经过处理后,计算机会给出一个判断。“例如判断人是否抑郁,是一个二分类的问题,答案表示为0或1,假设1是有抑郁倾向。”李文文说,

注意数据安全和大模型的偏见

AI潜力虽大,具体应用中还需考虑很多问题。

李文文团队在AI识别抑郁的研究中考虑到的一个问题是:人们主动分享在社交媒体上或者公开平台上的这些数据属于个人隐私吗?“我们发现有一些企业会主动爬取这些信息,利用这些信息进行商业分析,提高公司的效益。其中存在数字经济时代不可避免的数据交易问题:相关企业是否具有数据的所有权?它是否可以售卖相关用户的数据?”

在研究中,李文文团队很谨慎。她们收集的信息都是大家公开发表在论坛上的,且所有信息匿名化,她们不会对用户进行其他追踪。

另一个问题是,AI会不会对人造成二次伤害?“这可以和ChatGPT联系起来,如果在使用过程中,ChatGPT‘口出狂言’怎么办?这是一个非常糟糕的事情。我们一定会明令禁止它输出某些方面的内容,比如涉及歧视的、消极情绪的内容。”李文文说,“目前ChatGPT是一个通用的系统,不是为了某个特定任务而产生的产品,对一个特定任务来说,它现在的性能还不够。如果我们想让它帮助我们和特定人群进行沟通的话,涉及沟通技巧和专业知识,我们希望对它进行特别的训练,让它能够完成跟有抑郁倾向的人良好对话的目的。”

医疗健康领域涉及人的生命安全,如果AI进入这一领域,很多人担忧权责分配问题。李文文表示,目前基于AI的设备都是辅助诊断设备,最后的决定权掌握在医生手里,所以责任方是医生,她认为这也是AI的长期发展趋势。“我们不应该过分担忧AI会取代人类,而应该把AI视为一个工具。在人类的工作中,我们一直强调的是解决问题的能力,在未来,我们需要掌握使用AI工具解决问题的能力。”

(本文来自澎湃新闻,更多原创资讯请下载“澎湃新闻”APP)

当前位置:

当前位置: 来源:互联网转载

来源:互联网转载  作者:版权所有者

作者:版权所有者  时间:2023-04-12 02:01:33 发布

时间:2023-04-12 02:01:33 发布  标签:新闻

标签:新闻